Was ist Cloud-native Anwendungsentwicklung? Definition & Vorteile

Die Zahlen sprechen eine eindeutige Sprache darüber, wohin sich die Softwareentwicklung bewegt. Laut einer Studie von Gartner werden bis 2025 mehr als 95 % aller neuen digitalen Workloads auf cloud-nativen Plattformen bereitgestellt. Dies ist nicht nur ein weiterer Technologietrend – es stellt einen grundlegenden Wandel in der Herangehensweise von Organisationen an Softwareentwicklung und -bereitstellung dar.

Derzeit nutzen bereits 82 % der Unternehmen cloud-native Entwicklungsansätze und -tools. Was treibt diese Verbreitung voran? Cloud-native Anwendungen unterscheiden sich grundlegend von traditioneller Software in ihrer Architektur und ihren Fähigkeiten. Diese Anwendungen werden als lose gekoppelte, horizontal skalierbare Systeme entwickelt, die auf containerisierten und orchestrierten Plattformen laufen. Sie beinhalten typischerweise ein oder mehrere Konzepte, die speziell für die Cloud entwickelt wurden.

Die Attraktivität wird deutlich, wenn man die praktischen Vorteile betrachtet. Organisationen können Anwendungen dynamisch skalieren, indem sie Serverknoten je nach tatsächlicher Nachfrage hinzufügen oder entfernen. Diese Flexibilität löst eine der hartnäckigsten Herausforderungen traditioneller Softwarearchitektur – die Unfähigkeit, schnell auf sich ändernde Ressourcenanforderungen zu reagieren.

Dieser Artikel untersucht, was cloud-native Anwendungsentwicklung wirklich bedeutet, beleuchtet ihre zentralen Prinzipien und analysiert die konkreten Vorteile für die moderne Softwarebereitstellung. Zudem gehen wir auf die praktischen Überlegungen ein, mit denen sich Organisationen bei der Implementierung dieser Ansätze auseinandersetzen müssen.

Was ist Cloud-native Anwendungsentwicklung?

Die cloud-native Anwendungsentwicklung stellt einen grundlegenden Wandel in der Art und Weise dar, wie Software entwickelt und bereitgestellt wird. Cloud-native Anwendungen sind speziell von Grund auf dafür konzipiert, die Elastizität und die verteilte Natur der Cloud optimal zu nutzen – und nicht lediglich in der Cloud gehostet zu werden.

Definition einer cloud-nativen Anwendung

Eine cloud-native Anwendung ist eine Sammlung kleiner, unabhängiger und lose gekoppelter Dienste, die darauf ausgelegt sind, Geschäftswert durch bewährte Funktionalitäten zu liefern. Diese Anwendungen basieren auf einer Microservices-Architektur, bei der jeder Dienst unabhängig arbeitet, in einem eigenen Prozess läuft und über APIs oder Messaging kommuniziert. Cloud-native Technologien ermöglichen lose gekoppelte Systeme, die widerstandsfähig, verwaltbar und überwachbar sind.

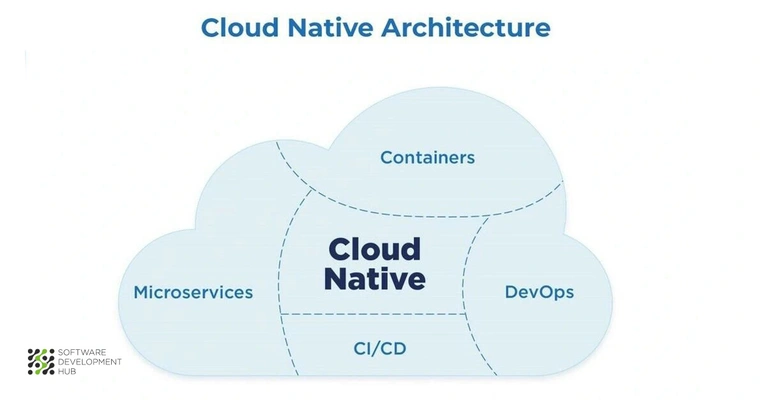

Der Begriff „cloud-native“ bezieht sich auf einen Ansatz, bei dem Softwareprogramme innerhalb des Cloud-Computing-Modells entwickelt und betrieben werden. Diese Methodik umfasst mehrere zentrale Technologien:

- Containerisierung zur Verpackung von Code mit seinen Abhängigkeiten

- Microservices für modulare Entwicklung

- DevOps-Praktiken zur Optimierung von Arbeitsabläufen

- Serverloses Computing zur dynamischen Ressourcenverteilung

Cloud-native Anwendungen integrieren typischerweise kontinuierliche Integration (CI) und kontinuierliche Bereitstellung (CD), sodass Entwickler regelmäßig Änderungen fehlerfrei in einen gemeinsamen Codebestand einpflegen können.

Wie sich cloud-native Modelle von cloud-enabled und cloud-ready Ansätzen unterscheiden

Das Verständnis der Unterschiede zwischen diesen Cloud-Modellen ist für Organisationen entscheidend, die ihre Entwicklungsstrategien bewerten möchten.

Cloud-enabled Anwendungen sind ursprünglich als lokale Unternehmensanwendungen konzipiert worden, wurden aber so angepasst, dass sie in der Cloud ausgeführt werden können. Zwar lassen sie sich über Browser aufrufen, behalten jedoch ihre monolithische Struktur bei und bieten nicht die Flexibilität, Ausfallsicherheit und Skalierbarkeit, wie sie cloud-native Anwendungen auszeichnen.

Cloud-ready Technologien wurden zwar während der Entwicklung teilweise in Cloud-Umgebungen getestet, jedoch nicht speziell für den Betrieb in der Cloud entwickelt. Sie erfordern häufig erhebliche IT-Ressourcen und Investitionen sowie aufwändige Aktualisierungen und Integrationen.

Cloud-native Anwendungen hingegen wurden ausschließlich für den Betrieb in der Cloud entwickelt. Sie nutzen die dynamische und verteilte Natur moderner Cloud-Infrastrukturen voll aus und bieten dadurch höhere Geschwindigkeit, Agilität, Skalierbarkeit, Zuverlässigkeit und Kosteneffizienz.

Kernprinzipien cloud-nativer Architekturen

Die cloud-native Architektur basiert auf fünf grundlegenden Prinzipien, die gemeinsam widerstandsfähige und skalierbare Anwendungen ermöglichen. Das Verständnis dieser Prinzipien ist für alle, die in der modernen Softwareentwicklung tätig sind, unerlässlich, da sie das technische Fundament für die zuvor genannten geschäftlichen Vorteile bilden.

Microservices für modulare Entwicklung

Der Microservices-Ansatz zerlegt monolithische Anwendungen in kleine, autonome Komponenten, die jeweils eine bestimmte Geschäftsfunktion übernehmen. Jeder Service arbeitet unabhängig, läuft in einem eigenen Prozess und kommuniziert über klar definierte APIs.

Dieses Architekturmodell bietet erhebliche Vorteile gegenüber traditionellen monolithischen Strukturen. Entwicklungsteams können gleichzeitig an unterschiedlichen Services arbeiten, ohne sich gegenseitig zu behindern. Müssen Änderungen vorgenommen werden, können einzelne Services angepasst werden, ohne die Stabilität der gesamten Anwendung zu gefährden.

Ein typisches Beispiel ist eine E-Commerce-Plattform. Anstatt eine große Anwendung zu entwickeln, können Teams separate Services für Benutzer-Authentifizierung, Produktkatalog, Zahlungsabwicklung und Bestellmanagement erstellen. Jeder Service kann je nach Geschäftsanforderung unabhängig aktualisiert, skaliert und bereitgestellt werden.

Containerisierung mit Docker und Kubernetes

Die Containerisierung verpackt Anwendungen zusammen mit all ihren Abhängigkeiten in standardisierte, portable Einheiten. Docker übernimmt die Erstellung und Verwaltung dieser Container, während Kubernetes ihre Orchestrierung über verteilte Systeme hinweg steuert.

Die praktischen Vorteile werden deutlich, wenn man Container mit herkömmlichen virtuellen Maschinen vergleicht. Container starten wesentlich schneller, da sie kein vollständiges Betriebssystem hochfahren müssen. Diese Geschwindigkeit ermöglicht eine rasche Skalierung und Bereitstellung – entscheidend für Anwendungen, die schnell auf veränderte Anforderungen reagieren müssen.

Zudem gewährleisten Container Konsistenz über verschiedene Umgebungen hinweg. Eine Anwendung, die auf dem Laptop eines Entwicklers läuft, verhält sich identisch in Staging- und Produktionsumgebungen – das häufige „bei mir funktioniert’s“-Problem gehört damit der Vergangenheit an.

Zustandslose Verarbeitung und Elastizität

Zustandslose Anwendungen behandeln jede Anfrage unabhängig, ohne Sitzungsinformationen zwischen den Anfragen zu speichern. Dieses Designmuster ermöglicht echte Cloud-Elastizität – die automatische Skalierung von Ressourcen entsprechend der tatsächlichen Nachfrage.

Die finanziellen Auswirkungen sind erheblich: Organisationen zahlen nur für die Ressourcen, die sie tatsächlich nutzen, und vermeiden sowohl Über- als auch Unterprovisionierung. Dieses Modell eignet sich besonders für Anwendungen mit schwankender Auslastung.

E-Commerce-Plattformen während des Weihnachtsgeschäfts sind ein gutes Beispiel. Der Datenverkehr kann bei Sonderaktionen stark ansteigen und danach wieder auf Normalniveau sinken. Durch den zustandslosen Aufbau können diese Plattformen in Spitzenzeiten hochskalieren und danach wieder herunterfahren – eine Optimierung von Leistung und Kosten zugleich.

Serverloses Computing und verbrauchsbasierte Modelle

Serverloses Computing entfernt die Infrastrukturverwaltung vollständig aus der Gleichung der Softwareentwicklung. Entwickler konzentrieren sich ausschließlich auf das Schreiben von Code, während Cloud-Anbieter die gesamte Bereitstellung, Skalierung und Wartung der Server übernehmen.

Dieses Modell passt ideal zu einer verbrauchsabhängigen Preisgestaltung, bei der Organisationen nur für tatsächlich genutzte Ressourcen zahlen, anstatt für vorab zugewiesene Kapazitäten. Serverlose Architekturen können bei Nichtnutzung automatisch auf null skalieren, wodurch Leerlaufkosten entfallen – gleichzeitig bleibt die Fähigkeit erhalten, sofort auf Nachfragespitzen zu reagieren.

Dieser Ansatz eignet sich besonders für Anwendungen mit unvorhersehbarem oder intermittierendem Nutzungsverhalten. Entwicklungsteams können Funktionen erstellen und bereitstellen, ohne sich um das Servermanagement kümmern zu müssen. Dadurch können sie sich voll und ganz auf die Bereitstellung von geschäftlichem Mehrwert konzentrieren, anstatt Infrastruktur zu verwalten.

Die 8 größten Vorteile der cloud-nativen Anwendungsentwicklung

Cloud-native Architekturen bieten messbare Vorteile, die die Art und Weise, wie Organisationen Software entwickeln und bereitstellen, grundlegend verändern. Die folgenden acht Vorteile zeigen, warum immer mehr zukunftsorientierte Unternehmen auf diesen Ansatz setzen.

1. Schnellere Markteinführung durch CI/CD-Pipelines

Kontinuierliche Integration und Bereitstellung (CI/CD) automatisiert den Software-Release-Prozess und ermöglicht es Teams, Updates und Codeänderungen häufiger zu integrieren und bereitzustellen. CI/CD-Pipelines helfen Entwicklern, Fehler frühzeitig im Entwicklungszyklus zu erkennen und zu beheben, was den gesamten Feedbackprozess beschleunigt. Organisationen, die CI/CD-Praktiken implementieren, berichten über spürbare Verbesserungen bei wichtigen Kennzahlen wie Vorlaufzeit, Bereitstellungshäufigkeit und Änderungsfehlerquote.

2. Verbesserte Skalierbarkeit durch Container-Orchestrierung

Die Container-Orchestrierung automatisiert die Bereitstellung, Skalierung und Verwaltung containerisierter Anwendungen. Diese Automatisierung reduziert den manuellen Aufwand erheblich, insbesondere bei der Verwaltung groß angelegter Anwendungen. Laut IBM nutzen 70 % der befragten Entwickler inzwischen Lösungen zur Container-Orchestrierung. Kubernetes ermöglicht insbesondere das Clustering von Hosts über öffentliche, private oder hybride Clouds hinweg und eignet sich daher besonders für Anwendungen, die eine schnelle Skalierung erfordern.

3. Kosteneffizienz durch nutzungsbasierte Infrastruktur

Pay-as-you-go-Modelle vermeiden Ressourcenverschwendung, indem nur der tatsächliche Verbrauch abgerechnet wird. Dieser Ansatz gewährleistet eine optimale Leistung bei gleichzeitigem Ressourcenschutz und reduzierten Betriebskosten. Organisationen zahlen für die tatsächlich genutzte Bandbreite anstatt für vorab zugewiesene Kapazitäten, die möglicherweise ungenutzt bleiben. Diese Preisstruktur ermöglicht es Unternehmen mit schwankenden Arbeitslasten, Innovationen voranzutreiben und zu skalieren – ganz ohne hohe Anfangsinvestitionen.

4. Verbesserte DevOps-Zusammenarbeit und Automatisierung

DevOps-Praktiken vereinfachen Entwicklungsprozesse und fördern die Zusammenarbeit zwischen zuvor getrennt arbeitenden Teams. Diese Integration erleichtert die schnelle Anpassung an sich ändernde Marktanforderungen. In Kombination mit cloud-nativer Architektur schaffen Organisationen stabile Rahmenbedingungen für eine regelmäßige Softwarebereitstellung – und steigern so sowohl die Agilität als auch die Widerstandsfähigkeit ihrer Systeme.

5. Portabilität über Cloud-Umgebungen hinweg

Cloud-native Anwendungen können über verschiedene Anbieter hinweg – und sogar vor Ort in hybriden Modellen – betrieben werden. Diese Portabilität verhindert nicht nur vertragliche Anbieterbindung, sondern ermöglicht echte Arbeitslastmobilität. Teams können Anwendungen so entwerfen, dass sie auf jeder beliebigen Cloud-Plattform erstellt und bereitgestellt werden können, ohne auf proprietäre Tools angewiesen zu sein.

6. Hohe Verfügbarkeit und Fehlertoleranz

Fehlertoleranz wird in cloud-nativen Systemen auf mehreren Ebenen gewährleistet – von Datenredundanz bis hin zur Ausfallsicherheit der Steuerungsebene (Control Plane). Verteilte Architekturen mit automatischen Failover-Mechanismen sorgen für kontinuierlichen Datenzugriff und minimale Serviceunterbrechungen. Multi-Cluster-Bereitstellungen verteilen Arbeitslasten, um eine hohe Verfügbarkeit zu garantieren, wobei der Datenverkehr automatisch auf gesunde Cluster umgeleitet wird – basierend auf Echtzeit-Gesundheitsprüfungen.

7. Geringere Anbieterabhängigkeit durch offene Standards

Offene Standards ermöglichen eine nahtlose Kommunikation zwischen verschiedenen Cloud-Plattformen. Sie fördern Interoperabilität, Portabilität und Anbieterneutralität, sodass Unternehmen ihre Anwendungen mit minimalem Aufwand zwischen verschiedenen Anbietern verschieben können. Diese Flexibilität optimiert die Cloud-Ausgaben, da Unternehmen jederzeit den kostengünstigsten Anbieter wählen können.

8. Flexibilität für Legacy-Modernisierung und neue Projekte

Die cloud-native Entwicklung bietet Flexibilität sowohl für neue Projekte (Greenfield) als auch für die Modernisierung bestehender Systeme (Legacy). Für Greenfield-Anwendungen können Teams Systeme gezielt für Cloud-Umgebungen optimieren. Bei bestehenden Anwendungen helfen cloud-native Ansätze, die IT-Komplexität zu verringern, Prozesse flexibler zu gestalten und eine plattformübergreifende Zusammenarbeit zu ermöglichen. Organisationen, die Legacy-Systeme modernisieren, berichten von Produktivitätssteigerungen von bis zu 60 % durch die cloud-native Transformation.

Herausforderungen und strategische Lösungen bei der Einführung cloud-nativer Technologien

Was passiert, wenn die vielversprechenden Vorteile der cloud-nativen Entwicklung auf die Realität der Umsetzung treffen? Organisationen stellen schnell fest, dass die Einführung mehr erfordert, als nur die richtigen Technologien auszuwählen. Der Weg zu einer erfolgreichen cloud-nativen Transformation führt über die Bewältigung mehrerer miteinander verknüpfter Herausforderungen.

Komplexität und Dienstverflechtung in der Cloud managen

Cloud-Umgebungen erzeugen ein überwältigendes Volumen, eine große Vielfalt und hohe Geschwindigkeit von Telemetriedaten – insbesondere bei Microservices und containerisierten Anwendungen. Die Situation wird noch komplexer, wenn Unternehmen hybride und Multi-Cloud-Strategien einführen: 80 % der Entscheidungsträger im öffentlichen Sektor nutzen hybride Clouds, während 71 % mehrere Public-Cloud-Anbieter einsetzen. Dabei entstehen Datensilos durch verschiedene Agents und uneinheitliche Überwachungstools, was das Verständnis von Abhängigkeiten zwischen Anwendungen und digitalen Kanälen erschwert.

Diese Komplexität ist nicht nur ein technisches Problem – sie wirkt sich direkt auf die betriebliche Effizienz und Entscheidungsfindung aus. Teams haben häufig Schwierigkeiten, eine durchgängige Sicht auf verteilte Systeme zu behalten, was zu längeren Problemlösungszeiten und geringerer Systemzuverlässigkeit führt.

Schließung der Cloud-native-Kompetenzlücke

Die technischen Anforderungen der cloud-nativen Entwicklung übersteigen häufig das vorhandene Fachkräfteangebot am Markt. Über 85 % der befragten IT-Entscheidungsträger berichten, dass Fachkräftemangel ihre Fähigkeit beeinträchtigt, Geschäftsziele zu erreichen. Unternehmen stehen vor erheblichen Rekrutierungsproblemen: 44 % finden keine qualifizierten Kandidaten, und 98 % berichten von einem gewissen Maß an Cloud-Skill-Gap. Laut Weltwirtschaftsforum werden bis 2025 rund 50 % aller Beschäftigten eine Umschulung benötigen, da Unternehmen neue Technologien einführen.

Die Kompetenzlücke betrifft nicht nur technische Fähigkeiten, sondern auch operatives Know-how, Sicherheitspraktiken und architektonische Entscheidungsprozesse. Organisationen müssen in umfassende Schulungsprogramme investieren – oder riskieren suboptimale Implementierungen.

Sicherheitsrisiken in verteilten Systemen

Die Sicherheitsbedenken vervielfachen sich in verteilten Architekturen. Untersuchungen zeigen, dass 96 % der in Cloud-Infrastrukturen eingesetzten Container-Anwendungen von Drittanbietern bekannte Sicherheitslücken enthalten. Die Angriffsfläche vergrößert sich erheblich durch die Vielzahl an Microservices und Komponenten, die Angreifern mehr potenzielle Einstiegspunkte bieten. Fehlkonfigurationen stellen ein weiteres großes Risiko dar und treten besonders häufig in komplexen Cloud-Umgebungen auf.

Traditionelle Sicherheitsansätze erweisen sich oft als unzureichend für cloud-native Architekturen. Organisationen benötigen neue Strategien, die die Dynamik verteilter Systeme berücksichtigen, in denen Dienste ständig wechseln und über APIs kommunizieren.

Probleme bei Service Discovery und Observability

Wie überwacht man, was man nicht sehen kann? Service Discovery wird in dynamischen cloud-nativen Umgebungen sowohl essentiell als auch herausfordernd. Dienste ändern ständig ihre Standorte, bedingt durch Faktoren wie Auto-Scaling und Upgrades. Observability ist schwierig, da eine effektive Überwachung und Messung über verteilte Systeme hinweg oft nicht möglich ist. Organisationen kämpfen häufig mit heterogenen Datenquellen, was das Verständnis von Abhängigkeiten nahezu unmöglich macht.

Ohne angemessene Observability arbeiten Teams im Blindflug, können Probleme nicht proaktiv erkennen oder die Leistung ihrer verteilten Anwendungen optimieren.

Platform Engineering als Lösung

Platform Engineering begegnet diesen Herausforderungen durch die Schaffung interner Entwicklerplattformen (Internal Developer Platforms, IDPs), die die zugrunde liegende Komplexität abstrahieren. Gartner prognostiziert, dass dieser Ansatz bis 2026 von 80 % der IT-Unternehmen übernommen wird. Organisationen, die Platform Engineering einsetzen, berichten von erheblichen Verbesserungen: 30 % schnellere Markteinführung und eine vierfach höhere Bereitstellungshäufigkeit.

Dieser Ansatz verlagert den Fokus vom Management einzelner Werkzeuge und Prozesse hin zur Entwicklung integrierter Plattformen, die die Produktivität der Entwickler fördern und gleichzeitig operative Exzellenz gewährleisten.

Die Zukunft der cloud-nativen Entwicklung

Die cloud-native Anwendungsentwicklung hat sich von einer experimentellen Technologie zu einer zentralen Geschäftsstrategie entwickelt. Die in diesem Artikel untersuchten Belege zeigen, wie Organisationen verschiedenster Branchen ihre Softwareentwicklungspraktiken umgestalten, um den Anforderungen moderner Märkte gerecht zu werden.

Die Entwicklung der Einführung spricht für sich. Organisationen, die cloud-native Methoden übernommen haben, berichten über messbare Verbesserungen bei der Bereitstellungshäufigkeit, der Markteinführungszeit und der betrieblichen Effizienz. Es geht hierbei nicht einfach darum, Technologietrends zu folgen – sondern darum, sich in zunehmend dynamischen Märkten einen Wettbewerbsvorteil zu sichern.

Was die cloud-native Architektur besonders wertvoll macht, ist ihre Ausrichtung auf moderne geschäftliche Anforderungen. Microservices ermöglichen es Teams, unabhängig zu arbeiten und schneller zu implementieren. Containerisierung gewährleistet Konsistenz zwischen Entwicklungs- und Produktionsumgebungen. API-First-Design erleichtert die Integration mit Drittanbieterdiensten und internen Systemen. Zustandslose Verarbeitung bietet die Elastizität, die moderne Anwendungen benötigen.

Die geschäftlichen Vorteile gehen weit über technische Verbesserungen hinaus. Organisationen, die CI/CD-Pipelines implementieren, berichten über eine schnellere Reaktion auf Marktveränderungen. Container-Orchestrierung reduziert den operativen Aufwand. Nutzungsbasierte Infrastrukturmodelle stimmen die Kosten auf den tatsächlichen Verbrauch ab. DevOps-Praktiken überwinden traditionelle Silos zwischen Entwicklungs- und Betriebsteams.

Die cloud-native Entwicklung verändert grundlegend, wie Software geschäftliche Ziele unterstützt. Anstatt Anwendungen als statische Systeme zu betrachten, können Organisationen jetzt Software entwickeln, die sich dynamisch an veränderte Anforderungen anpasst. Diese Fähigkeit ist für Unternehmen, die schnell auf Marktchancen und Kundenanforderungen reagieren müssen, unerlässlich geworden.

Der Wandel hin zu cloud-nativen Ansätzen stellt mehr dar als eine technologische Weiterentwicklung – er spiegelt einen umfassenderen Wandel darin wider, wie Unternehmen über Softwarefähigkeiten wettbewerbsfähig bleiben. Organisationen, die diese Ansätze beherrschen, positionieren sich so, dass sie schneller innovieren und effektiver auf Marktveränderungen reagieren können als diejenigen, die weiterhin auf traditionelle Entwicklungsmethoden setzen.

Categories

About the author

Share

Neueste Beiträge

Benötigen Sie einen Projektkostenvoranschlag?

Schreiben Sie uns, und wir bieten Ihnen eine qualifizierte Beratung.